每日經濟新聞 2023-04-24 14:37:16

◎ 當大廠跑出自己的路子,小企業就有機會站在巨人的肩膀上。

每經記者 李孟林 蘭素英 文巧 每經編輯 蘭素英

ChatGPT的火爆帶動了國內對大語言模型的開發熱潮。從百度3月份發布“文心一言”以來,不到兩個月,國內互聯網大廠、AI企業和初創團隊陸續官宣了約10個大模型項目。此番熱鬧場景讓不少人感慨:自從“千團大戰”之后,中國互聯網產業已經有十年沒有如此“卷”過了。

面對英偉達CEO黃仁勛所謂的AI“iPhone”時刻,沒有人愿意被甩在“大模型時代”的浪潮身后。然而,“煉大模型”需要的是天量的算力支持和資金投入,據悉,僅硬件上的投資就需要30億元,這無疑考驗著參與者的資金實力和戰略定力。

AI大模型最終將是大廠之間的“游戲”嗎?中小企業的機會又在哪里?《每日經濟新聞》采訪了多家互聯網大廠、逐浪AI的創業者及行業人士,一窺這場競速賽中的發展現狀。

隨著ChatGPT的現象級爆紅,國內科技領域的創業熱情也被點燃。一時間,打造“中國版OpenAI”和類ChatGPT產品成為最熱門的話題和趨勢。

互聯網大廠自然不會錯失這樣的機遇。百度已率先推出“文心一言”,阿里巴巴發布“通義千問”,華為也介紹了“盤古”大模型的最新進展……

據《每日經濟新聞》記者的不完全統計,今年3月~4月,已經約有10家企業及機構發布大模型或啟動大模型測試邀請。接下來,蓄勢待發的還有騰訊的“混元”、京東的“言犀”、字節跳動的自研大模型等一系列大模型。

大廠之外,還有許多重量級科技大佬也已高調入局。原美團聯合創始人王慧文、前搜狗CEO王小川、創新工場董事長兼首席執行官李開復等相繼成立初創公司,投身AI大模型創業。

圖片來源:每經記者 蘭素英制圖

一場“百模大戰”就此在國內全面拉開序幕。

一名不愿具名的硅谷大模型工程師認為,國內現在的大模型領域有點過熱。“在海外,搞大模型的其實就那么幾家。在國內,競爭對手的數量是美國的幾倍,而市場就這么大。”他告訴《每日經濟新聞》記者。

這種熱到發燙的形勢也讓許多人質疑,蜂擁的投入能不能在商業價值上帶來回報。長期關注芯片產業的集微咨詢資深分析師錢禹對《每日經濟新聞》記者表示,“我個人覺得是有機會的,因為現在的AIGC(AI生成內容)產品的準確性和效率的優勢是非常明顯的。”他認為,互聯網和AI的商業模式靈活度很高,未來既可做API或者SDK開發包的授權,也可以參與硬件業務,探索to B和to C的服務。

圖片來源:阿里云提供

隨著眾多玩家“入局”大模型研發,一場關于算力的爭奪戰也打響了。

在業內,開發大語言模型被戲稱為“煉大模型”,是一個“大力出奇跡”的模式,指的就是依靠巨大算力訓練海量數據后“涌現”出的對答如流能力。ChatGPT的成功就得益于微軟慷慨的資金和算力支持。美國市場研究機構TrendForce推算稱,處理ChatGPT的訓練數據需要2萬枚GPU芯片,而隨著OpenAI進一步展開ChatGPT和其他GPT模型的商業應用,其GPU需求量將突破3萬張(該報告計算以A100芯片為主)。

行業人士普遍認為,1萬顆A100芯片是訓練大模型的入門券。馬斯克4月17日表示,他要開發一款名為“TruthGPT”的AI模型,叫板ChatGPT。據外媒報道,馬斯克已經為搭建大模型購入了1萬張A100芯片。

“現在(國內大模型廠商面臨的)問題是買不到芯片。對于目前訓練大模型的主流芯片,例如英偉達GPU A100和(更新一代的)GPT H100,市場上所有的公司都在搶貨。一個公司能搶到多少?”上述硅谷工程師反問道,“國內真正有萬卡級別的公司是鳳毛麟角。”

據此前媒體報道,國內擁有超過1萬枚GPU的企業不超過5家,且多為英偉達中低性能產品,而擁有1萬枚A100芯片的企業最多只有一家。

在A100這樣的“香餑餑”短缺的情況下,英偉達在國內市場推出了A100的低配版A800和專為ChatGPT研發的H100芯片的“特供版”芯片H800,但A800和H800的數據傳輸速率相比A100分別下降了30%和50%。有業內人士對媒體表示,H800國內已經少量出貨,但新近下的訂單可能要年底才能到貨。

互聯極簡聯合創始人&CTO馬力遙告訴《每日經濟新聞》記者,目前市場上有一些存量A100芯片,更多的是用A800在做芯片替代。他所在的公司就專注于應用私有數據微調大模型,服務垂直行業。錢禹估計,國內的互聯網公司或算法公司之前肯定對英偉達芯片做了儲備,不過具體數量不好量化。

百度、阿里等大廠以及國內芯片廠商也在自研芯片,但錢禹指出,目前這些自研芯片主要還是部署在大模型的推理階段,而非要求更高的訓練階段。

即便市場上芯片供應充足,但也不是每個入局者都能玩得起的,擋在他們面前的不僅是高昂的成本,還有協同發揮硬件設施的能力。

圖片來源:每經記者蘭素英制圖

1)燒錢的GPU

取決于購買量和英偉達的折扣政策,一顆80GB的A100芯片在國外的定價為1萬~1.5萬美元(約合人民幣68800~103300元)之間。

《每日經濟新聞》記者注意到,目前京東售賣的的80GB A800芯片價格為89999元(約13079美元),而庫存僅剩數張。有媒體報道稱,實際上A800現在處于“有價無市”的情況,供應緊張,真實成交價格高于平臺報價。即便按89999元一顆A800芯片的價格計算,1萬顆的成本就是約人民幣9億元。

更重要的是,這還只是GPU芯片部分的成本,并非全部的硬件投入花費。錢禹對《每日經濟新聞》記者指出,除GPU外,建設數據中心還需要ASIC或FPGA類專用芯片、服務器CPU芯片,以及服務于分布式訓練硬件架構的光模塊通信芯片。搭建一臺服務器,刨除GPU芯片成本,還需要3萬元到4萬元的成本。據估算,一臺服務器多由8顆GPU組成,那1萬顆GPU就意味著1250臺服務器,所涉及的GPU之外的成本就還需要3750萬~5000萬元。

業內估計,服務器的采購成本通常為數據中心建設成本的30%,按此推算,一個服務于大模型的數據中心建設成本或超過30億元。

2)不只是GPU

構建大模型的計算基礎設施,不僅是簡單的硬件堆砌,更需要實際搭建過程中積累的know-how(實踐知識)。

“大模型訓練離不開密集型計算算力,今天模型的訓練往往會以有多少張卡來表示背后的算力,其實這是一個非常簡單的描述,”阿里云CTO周靖人對《每日經濟新聞》記者表示。

他進一步指出,“所有GPU不是簡簡單單的堆砌,更需要的是讓所有GPU,讓異構算力能夠聯合起來去為我們的模型訓練服務。我們有成千上萬的模塊,如何幫助他們有效地高速連接起來,如何能夠提供一個高吞吐、低延遲的網絡方案,對模型訓練是至關重要的。”此外,完善的大規模的數據存儲和低延遲的網絡方案同樣重要。

前述硅谷工程師也認為,就算是現在市面上能直接商業化買到的最強算力策略,也很難建設一個特別大的計算機群,因為連接芯片用的是電,而電的衰減很快,一般來說只能達到百卡互聯的量級。

“如果是距離較近的芯片連接,你可能感受不到損耗;但如果距離稍微遠一點,例如說機器在10米遠的地方,想把兩個卡連在一起,電的損耗實際上是非常大的。”他對記者解釋稱。

3) 訓練和運營成本

硬件搭建完成后,大模型的訓練花費也不菲。馬力遙對記者透露,訓練大模型門檻非常高,GPT-4的訓練成本據估計達到了10億美元,是GPT-3的5倍。在他看來,大模型的訓練絕對是少數人的游戲。

此外,錢禹還指出,若芯片性能不足,那模型的訓練效率就會受到巨大影響。“比如一個大模型,用英偉達可能一個月就訓練好了,但如果訓練卡算力沒有人家那么好,那訓練三個月或者半年都是有可能的。”而如果要加快訓練速度,電力消耗就會攀升。

原騰訊副總裁、自然語言模型專家吳軍此前就在一次直播分享中形象地描繪了大模型訓練中的電力成本:ChatGPT訓練一次需要耗費的電量,相當于3000輛特斯拉電動車每輛跑20萬英里(32萬公里)的耗電量。

一旦推出,每天的用戶訪問也需要大量算力支撐。相比訓練階段,大規模運營的推理階段對算力要求更高。

半導體研究公司SemiAnalysis認為,ChatGPT大規模服務用戶的成本遠超訓練成本,以GPT-3模型推算,ChatGPT每天的運營成本高達70萬美元,新一代的GPT-4模型只會更燒錢。按每日70萬美元計算,則ChatGPT一年的運營成本高達2.555億美元(約17.6億人民幣)。

國盛證券則從電費角度進行了分析,以英偉達A100芯片、DGX A100服務器、現階段每日2500萬訪問量等假設為基礎,ChatGPT的初始投入成本約為8億美元(約合人民幣55億元),對應約4000臺服務器,每日運行電費約為5萬美元。

這還沒算人力成本,高昂的投資意味著只有手握云計算、數據資源和資金實力的幾家大廠才能承擔開發大模型的成本。

圖片來源:視覺中國-VCG41N1356593648

實際上,在巨額的投入面前,部分一開始激動不已的創業者也逐漸冷靜。

出門問問創始人、前谷歌科學家李志飛曾在2月份第一個喊出做中國OpenAI的口號,但在近期的采訪中,他已經轉變思路,放棄了從零開始“煉大模型”的思路。他在一次采訪中提到, “兩個月以前,我就是要復制ChatGPT,但現在我覺得不想清楚商業模式到最后會很痛苦。”

那在這場AI“軍備賽”中,各路玩家的機會在哪里?

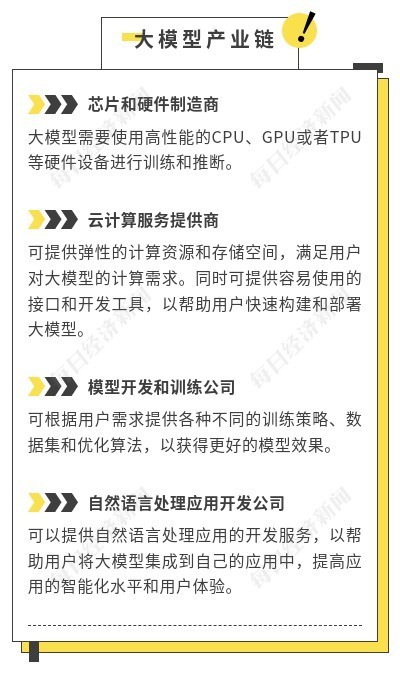

馬力遙告訴《每日經濟新聞》記者,大模型產業主要分為三大塊:最底層是芯片,中間是大模型,最上面是大模型的開發應用。

圖片來源:每經記者 蘭素英制圖(資料整理自采訪內容)

英國工程技術協會會員、Frelan GPT的開發者張冶對《每日經濟新聞》記者表示, “在日新月異的AI行業,每個層級的廠商都有著自己的任務和使命。頭部的廠商有著大量的財力人力,應該專注在核心技術的研發以及算法的迭代,把大部分的精力用于應對國際上激烈的競爭。中小型企業應著重技術應用,并且靈活的方式應對活躍的市場,并反哺頭部大廠。”

當大廠跑出自己的路子,小企業就有機會站在巨人的肩膀上。前述硅谷工程師以MidJourney為例解釋說,“MidJourney實際上是一個非常小的公司。新時代的公司不會說‘賣漢堡是從養牛做起’,我們都是基于一個平臺,上面接亞馬遜云等,站在巨人的肩膀上,能以很快的速度就做很多的事情,獲得高關注度和高收益。”

4月20日,出門問問發布了自家的百億參數級的多模態大模型“序列猴子”。李志飛表示,未來公司將聚焦在算法層面的研發和迭代,不做硬件,在商業化上側重于面向B端的企業定制類服務,“這會比一個通用大模型可能更加有用。”

目前,在大模型上走在前列的大廠,也在積極推動把自己的算力和模型開放給第三方企業使用,從而降低中小企業開發模型的成本,一個分工有序的大模型生態正在形成之中。阿里云和商湯科技就對《每日經濟新聞》記者表示,他們可為企業提供大模型服務或算力服務,騰訊和字節跳動近期也推出了面向大模型開發的算力服務。

錢禹認為,像王小川和王惠文這樣的創業團隊,可以把精力放在算法和模型上,服務器硬件和訓練數據可以找合作伙伴,“比如說我給阿里提需求,我需要這樣的服務器和這樣的算力,你來給我配置。”

另一方面,中小企業也可以利用大廠的模型做二次開發。“比如說文言文的研究我是比較專業的,那我可能把百度的模型拿來借鑒一下,在此基礎上做一個深度開發,然后實現文言文的聊天,這是完全可以的。”錢禹表示。

專注垂直行業的馬力遙對此也深以為然。

他告訴《每日經濟新聞》記者,初創企業可根據其核心能力和市場地位選擇創業方向,只要掌握私有數據和充沛的業務知識,仍可打造其行業壁壘。他強調,要在應用層實現突破,一定要把握垂直行業企業客戶的痛點,有的放矢,一定要具備私有的高質量數據、對大模型能力的充分利用能力和對行業的深刻理解,有效結合這三者才能產生實實在在的商業價值。

“一個再聰明的孩子,如果沒有高質量的數據教導,也是不可能成材的。例如Stack Overflow,OpenAI就是用這個平臺上的高質量數據來訓練代碼的生成。”前述硅谷工程師也對記者如是說道。

更重要的是,利用垂直領域數據對大模型微調的成本已經達到中小企業可以接受的范圍。馬力遙以開源聊天機器人 Vicuna-13B為例對記者解釋道,這款通過 LLaMA 模型微調和 ShareGPT 用戶共享對話訓練而成的機器人的訓練成本僅為 300 美元(約合人民幣 2060 元),而質量可達 OpenAI ChatGPT 和 Google Bard 的 90% 以上。

封面圖片來源:視覺中國-VCG41N1356593648

如需轉載請與《每日經濟新聞》報社聯系。

未經《每日經濟新聞》報社授權,嚴禁轉載或鏡像,違者必究。

讀者熱線:4008890008

特別提醒:如果我們使用了您的圖片,請作者與本站聯系索取稿酬。如您不希望作品出現在本站,可聯系我們要求撤下您的作品。

歡迎關注每日經濟新聞APP