每日經濟新聞 2023-05-26 08:15:40

每經編輯 王月龍

”眼見“不一定”為實“之后,怎么辦?

繼此前“10分鐘被AI換臉騙走430萬元”事件引發關注之后,5月25日,4月發生的又一起AI換臉詐騙事件被媒體曝光。這次金額達到245萬,且整個詐騙過程時間更短,只有9秒鐘。

在前一天,中國互聯網協會發文提醒,不法分子利用AI技術,通過聲音合成,偽造成特定人物的聲音,通過AI換臉,偽裝成特定人物,實時與他人進行視頻通話。更換后的面部表情自然,以假亂真,能夠冒充他人身份聯系被害人,博取被害人信任后實施詐騙。面對利用AI技術的新型騙局,廣大公眾需提高警惕,加強防范!

圖片來源:視覺中國

9秒被騙走245萬

“打了視頻電話又是熟人”

據大皖新聞報道,今年4月,安徽安慶經開區發生一起“冒充熟人”詐騙案,經開公安分局反詐中心民警調查發現詐騙分子使用了一段9秒鐘的智能AI換臉視頻佯裝“熟人”,讓受害人放松警惕從而實施詐騙。

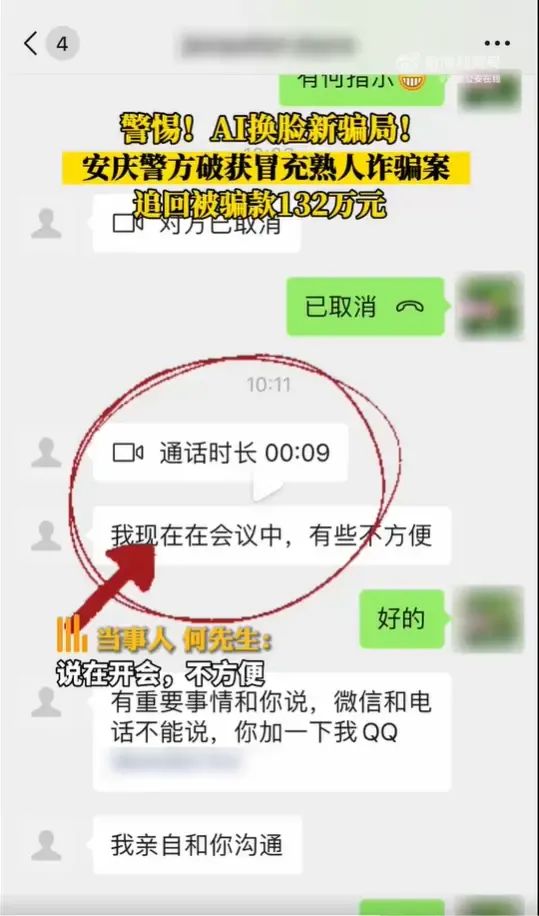

“視頻里邊我看到是他的臉”,“但是沒幾秒就掛了,說在開會不方便”。4月27日,何先生的微信“好友”突然向其發起視頻通話,電話接通后,何先生看到“好友”正在一間會議室內,就在他準備進一步詢問時,“好友”直接掛斷了電話,并表示在會議中有重要事情交代,需要何先生添加QQ溝通。

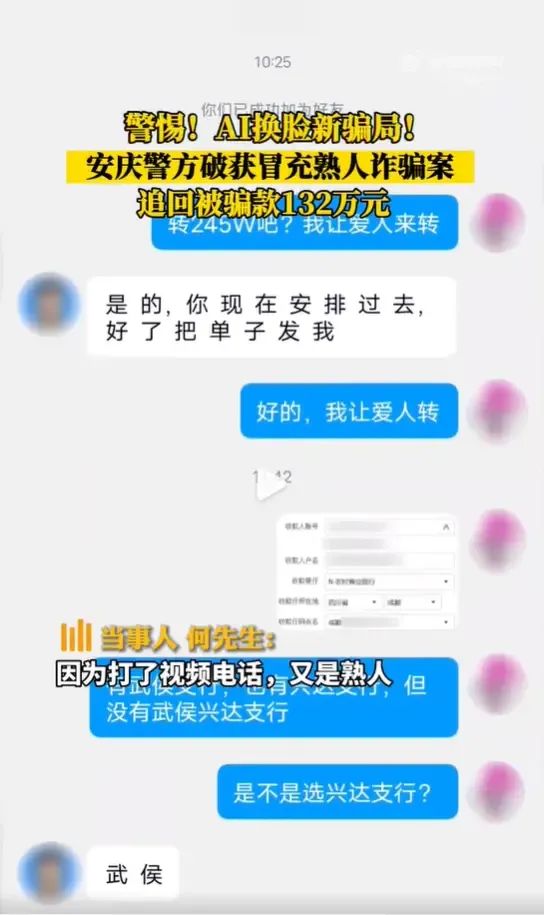

隨后,“好友”在QQ上告訴何先生,目前有一個項目招標需要周轉資金,希望何先生先行幫忙墊付。“因為打了視頻電話又是熟人”,“我就沒多想,就轉賬了”,基于對“熟人”的信任,何先生沒有猶豫,立刻讓家人將245萬元到對方指定的賬號上,直到事后撥打對方電話才得知被騙。

發現被騙之后,何先生迅速報警,接報案后,安慶經開公安分局立即抽調精干警力組成專案組第一時間對涉案賬戶的資金流、信息流進行查詢追蹤。4月28日,專案民警連夜趕赴北京市抓獲3名涉詐嫌疑人。5月22日,警方將先行追回的132萬元被騙款及時返還給何先生,目前案件正在進一步偵辦中。

AI換臉、換聲詐騙怎么防?

回撥電話、觀察畫面

5月24日,中國互聯網協會發布公告,面對利用AI技術的新型騙局,廣大公眾需提高警惕,加強防范。中國互聯網協會表示,伴隨著深度合成技術的開放開源,深度合成產品和服務逐漸增多,利用“AI換臉”“AI換聲”等虛假音視頻進行詐騙、誹謗的違法行為屢見不鮮。

中國互聯網協會表示,在AI時代,文字、聲音、圖像和視頻都有可能是深度合成的,在轉賬匯款、資金往來這樣的典型場景,要通過回撥對方手機號等額外通信方式核實確認,不要僅憑單一溝通渠道未經核實就直接轉賬匯款,無論對方是誰。

據界面新聞,針對使用AI換臉、擬聲技術進行詐騙的案例,小冰公司CEO李笛表示,目前了解到的用AI換臉的詐騙團隊,主要是采用Wav2Lip這種開源技術,通過音頻去驅動口型。“但是在某些口型上是會出現問題的,比如嘟起嘴時的口型錯誤、邊緣抖動,或者口型朝向與五官不搭配等等。”

瑞萊智慧聯合創始人、算法科學家蕭子豪也表示,在視頻通話時可以通過讓對方做一些大幅度的搖頭、張嘴之類的動作,“如果黑產做的模型不太精細、只做了正臉的情況下,突然露齒時生成的牙齒或舌頭就不會特別清晰,耳朵處也可能會出現不正常的陰影。”

據蕭子豪介紹,從技術角度辨別內容是否經過深度偽造同樣有跡可循,辨別思路大致可分為兩種,一種是尋找圖像編輯痕跡,另一類則是判斷行為是否符合常識。

人工智能詐騙接二連三

更高層面監管亟須落地

據證券時報,“人工智能教父”杰弗里·辛頓今年年初就曾經警告,人工智能對人類構成的威脅將比氣候變化更加緊迫。辛頓認為,人工智能是一種智能工具,可以輔助人類做一些繁瑣、重復和創意性工作,但也會有不法之徒用它來做違法亂紀的勾當。人工智能不但能撰寫文章,還能生成圖像、視頻。如果用來弄虛作假,幾乎可以亂真,普通人很難識別出來。如果有人用它來制作虛假圖像、視頻,傳遞錯誤信息,其破壞力遠大于單純的文字形式。

據新華網,“短短10分鐘,被騙430萬元”“換臉冒充當紅女星帶貨,賺得盆滿缽溢”……這種“換臉”術和擬聲術,讓人防不勝防。如此種種,無不說明換臉術的濫用,已經對公共利益構成威脅。

針對技術手段日益更新的AI詐騙事件,2022年11月25日,國家互聯網信息辦公室、工業和信息化部、公安部聯合發布《互聯網信息服務深度合成管理規定》(以下簡稱規定),自2023年1月10日起施行。規定要求深度合成服務提供者對使用其服務生成或編輯的信息內容,應當添加不影響使用的標識。提供智能對話、合成人聲、人臉生成、沉浸式擬真場景等生成或者顯著改變信息內容功能的服務的,應當進行顯著標識,避免公眾混淆或者誤認。要求任何組織和個人不得采用技術手段刪除、篡改、隱匿相關標識。

今年4月11日,國家網信辦起草了《生成式人工智能服務管理辦法》(征求意見稿),提出AI內容必須真實準確,其中也明確提到,禁止非法獲取、披露、利用個人信息和隱私、商業秘密。

為此破局,一方面要強化公共宣教,確立新的防騙反詐意識;另一方面,更重要的還是加快防御性、對抗性技術工具的推廣落地和應用嵌入。比如說,不妨嘗試在常用的社交媒介軟件中,內嵌入聲紋、人臉識別的身份核驗模塊等。

編輯|王月龍?杜恒峰

校對|劉小英

每日經濟新聞綜合自大皖新聞、界面新聞、證券時報、新華網、中國互聯網協會

如需轉載請與《每日經濟新聞》報社聯系。

未經《每日經濟新聞》報社授權,嚴禁轉載或鏡像,違者必究。

讀者熱線:4008890008

特別提醒:如果我們使用了您的圖片,請作者與本站聯系索取稿酬。如您不希望作品出現在本站,可聯系我們要求撤下您的作品。

歡迎關注每日經濟新聞APP