每日經濟新聞 2024-06-06 18:10:11

每經編輯 黃勝 每經實習編輯 宋欣悅

當地時間4日,13位來自OpenAI和Google的現任及前任員工聯合發布了一封公開信,引發廣泛關注。這些員工在信中表達了對人工智能技術潛在風險的嚴重擔憂,并呼吁相關公司采取更加透明和負責任的措施來應對這些風險。

這封公開信由多位知名人士聯名背書,包括被譽為“人工智能教父”的杰弗里•辛頓(Geoffrey Hinton)、因開創性AI研究獲得圖靈獎的約書亞•本吉奧(Yoshua Bengio)以及AI安全領域的學者斯圖爾特•羅素(Stuart Russell)。

圖片來源:Right To Warn AI

信中指出,盡管人工智能技術可能會給人類帶來巨大益處,但其帶來的風險同樣不容忽視。這些風險包括加劇社會不平等、操縱和虛假信息傳播,以及自主AI系統失控可能導致的人類滅絕。信中強調,這些風險不僅得到了人工智能公司本身的確認,也得到了世界各國政府和其他AI專家的認可。

公開信簽署者們表示,他們希望在科學界、政策制定者和公眾的指導下,能夠充分緩解這些風險。然而,他們擔心,人工智能公司由于強烈的經濟動機,可能會避免接受有效的監督。他們認為,僅靠現有的公司治理結構不足以解決這一問題。

信中還提到,人工智能公司掌握著大量關于其系統能力和局限性、保護措施的充分性以及各種風險水平的非公開信息。然而,這些公司目前對與政府分享信息的義務很弱,且完全沒有義務與公眾分享。簽署者們認為,不能完全依賴這些公司自愿分享信息。

信中提到,由于嚴格的保密協議,員工們在表達對AI風險的擔憂時,面臨著種種限制。而目前對于舉報人的保護措施尚存在不足,一些員工擔心因提出批評而遭受報復。

聯名信呼吁人工智能公司承諾員工對公司提出風險相關的批評時,不對其進行打擊報復,建立匿名舉報機制,支持開放批評的文化,并保護員工公開分享風險相關信息的權利。

圖片來源:X

OpenAI前員工丹尼爾•科泰洛 (Daniel Kokotajlo)是此次聯名信公開署名人員中的一位。他在社交平臺上連發15條消息表示:“我們中一些最近從OpenAI辭職的人聚集在一起,要求實驗室對透明度作出更廣泛的承諾。”

丹尼爾提到,他今年四月辭職,是因為對該公司在構建通用人工智能方面是否會采取負責任的行為失去了信心。他指出,盡管他希望公司在AI功能越來越強大的同時,能在安全研究方面投入更多資金,但OpenAI并未做出相應調整,導致多名員工相繼辭職。

他強調,OpenAI等實驗室構建的系統有能力給人類社會帶來巨大的好處,但如果不謹慎處理,長期來看,可能是災難性的。他還提到,當前AI技術幾乎未收監管,主要是公司在進行自我監管,而這種方式存在巨大的風險。

丹尼爾透露,離職時他被要求簽署一份“封口協議”,其中包含一項不貶損條款,禁止他發表任何批評公司的話,否則將失去已歸屬的股權。然而,他在深思熟慮后,依舊決定放棄簽署協議。

圖片來源:Dwarkesh Podcast

此外,6月4日,OpenAI前超級對齊部門成員利奧波德•阿申布倫納(Leopold Aschenbrenner)也在播客節目Dwarkesh Podcast中透露他被開除的真實原因:他給幾位董事會成員分享了一份OpenAI安全備忘錄,結果導致OpenAI管理層不滿。

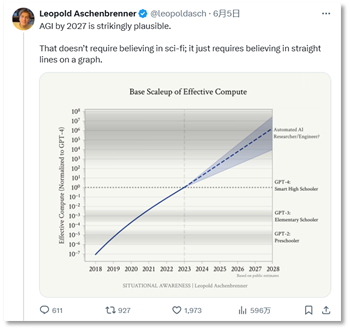

利奧波德在社交平臺表示,到2027年實現AGI是極其有可能的,需要更嚴格的監管和更透明的機制,確保人工智能的安全發展。

圖片來源:X

此前,OpenAI原首席科學家伊利亞•蘇茨克維(Ilya Sutskever)和前安全主管、超級對齊團隊負責人楊•萊克(Jan Leike)相繼離職。

萊克在離職后,公開批評了OpenAI的管理層,指責其追求華而不實的產品,忽視了AGI(通用人工智能)的安全問題。他稱OpenAI領導層關于公司核心優先事項的看法一直不合,超級對齊團隊過去幾個月一直在逆風航行,在提升模型安全性的道路上受到公司內部的重重阻礙,“(OpenAI)安全文化和安全流程已經讓位給閃亮的產品”。

圖片來源:X

每日經濟新聞綜合公開消息

封面圖片來源:每日經濟新聞 資料圖

如需轉載請與《每日經濟新聞》報社聯系。

未經《每日經濟新聞》報社授權,嚴禁轉載或鏡像,違者必究。

讀者熱線:4008890008

特別提醒:如果我們使用了您的圖片,請作者與本站聯系索取稿酬。如您不希望作品出現在本站,可聯系我們要求撤下您的作品。

歡迎關注每日經濟新聞APP